Aunque la comunicación inalámbrica, especialmente en la concurrida banda ISM, está cargada de peligros ocultos, colaboradores de IEEE y Wi-Fi Alliance han conseguido guiar con éxito la tecnología LAN inalámbrica desde sus modestos comienzos hasta la razonable fiabilidad y el alto rendimiento del que disfrutamos hoy en día.

Las redes de área local (conocidas por su acrónimo en inglés LAN) demostraron su utilidad ya en los años 80, mucho antes de que la conexión a Internet se convirtiera en algo habitual. Estas redes permitían a los usuarios utilizar impresoras compartidas, conectarse a servidores de ficheros, enviar correos electrónicos, etc. Una década más tarde, con el auge de Internet, las redes de área local se convirtieron en una vía de acceso a las autopistas de la información. La tecnología más habitual en redes de área local era Ethernet, que sería una solución estupenda si no fuera por un gran inconveniente: esos molestos cables.

A finales de los 90, el Instituto de Ingenieros Eléctricos y Electrónicos (Institute of Electrical and Electronic Engineers, IEEE) resolvió el problema con su estándar 802.11, que especificaba los protocols para crear redes de área local sin hilos. Es más fácil decirlo que hacerlo. La construcción de redes inalámbricas rápidas y fiables suponía múltiples retos. Pero esos retos se superaron como explicaremos a continuación.

Aloha: Principios y fundamentos

El periplo empezó a principios de los 70. La universidad de Hawái tenía instalaciones en las diferentes islas del archipiélago, pero los ordenadores se encontraban en el campus principal en Honolulu. Por aquel entonces los ordenadores no eran para nada portables. Los usuarios se conectaban a los ordenadores centrales utilizando terminales remotos y una conexión telefónica a la pasmosa velocidad de 300 o 1200 bits por segundo. Estas conexiones eran lentas y poco fiables.

Un pequeño grupo de pioneros de las redes de ordenadores, encabezados por Norman Abramson, pensó que era posible diseñar un sistema alternativo para conectar los terminales remotos a las instalaciones informáticas centrales de la universidad. La idea inicial, que se desarrolló con el nombre AlohaNET, consitía en utilizar comunicaciones radio para transmitir los datos desde los terminales a los ordenadores centrales y viceversa. En aquella época, la manera habitual de compartir un canal radio entre distintas estaciones consistía en dividir el canal en ranuras temporales o en diferentes franjas de frecuencia y asignar o bien una ranura temporal o bien una franja frecuencial a cada una de las distintas estaciones. Estos dos enfoques son popularmente conocidos por sus acrónimos en inglés TDMA (Time Division Multiple Access) y FDMA (Frequency Division Multiple Access).

Evidentemente, al dividir el canal radio en otros canales más pequeños (bien en tiempo o en frecuencia), los canales resultantes son de una velocidad menor al original. Los creadores de AlohaNET tenían en mente un método alternativo para compartir el canal radio. AlohaNET se diseñó con únicamente dos canales UHF de alta velocidad: uno descendente (desde Honolulu) y otro ascendente (hacia Honolulu). El canal ascendente debía compartirse entre todas las estaciones remotas que tenían que transmitir a Honolulu. Cada una de estas estaciones remotas tenía a su disposición todo el ancho de banda del canal de subida. El único problema era la posibilidad de que dos estaciones transmitieran al mismo tiempo, y en ese caso las transmisiones solapadas no se podían decodificar en Honolulu. Las transmisiones podían fallar, de la misma manera que los surfers podían caerse de su tabla al pillar olas en el Pacífico. Pero, bien, nada les impedía intentarlo de nuevo. Esta idea fundamental de reintentar la transmisión en caso de fallo, sirvió de base a toda una familia de protocolos que se conocen con el nombre de “protocolos de acceso aleatorio”.

El enfoque de acceso aleatorio implementado en AlohaNET suponía un cambio de paradigma, de una red orientada a soportar comunicaciones de voz a una red para comunicaciones de datos. Las técnicas tradicionales de compartición de canal (FDMA y TDMA) implicaban la reserva de un canal de baja velocidad para cada uno de los usuarios. Esa velocidad era suficiente para un canal de voz, y el hecho de que fuera reservado evitaba abruptas y molestas interrupciones.

Pero el tráfico de los terminales remotos a los ordenadores centrales presentaba unas características muy distintas a las comunicaciones de voz. Para empezar, el tráfico de los terminales remotos es tráfico a ráfagas. El usuario introduce un comando, espera a que el ordenador procese el comando y ejecute la tarea, recibe la respuesta del terminal y inspecciona los resultados mientras reflexiona sobre el próximo comando que va a introducir. Podemos observar que este patrón incluye largos periodos de silencio en los que no se transmite información y picos de transmisión en que se transmite una ráfaga de información.

El tráfico a ráfagas requería un uso más eficiente de los recursos radio disponibles para la comunicación que los que podían ofrecer TDMA o OFDMA. Si se le asignara a cada estación un canal de baja velocidad, la transmisión de una ráfaga de tráfico llevaría mucho tiempo. Además los recursos radio se malgastarían durante los largos periodos de silencio en los que no se transmite información. La solución está en un concepto que implementaba el protocolo de acceso aleatorio de AlohaNET y que es uno de los pilares de las redes de datos: la multiplexación estadística: un único canal de alta velocidad es compartido por distintos usuarios, pero cada uno de los usuarios lo utiliza sólo cuando lo necesita. Mientras Alicia está examinando la salida de su programa disfrutando de una taza de café, Bernardo puede estar subiendo datos al ordenador central para procesarlos posteriormente. Más tarde, se invierten los papeles y Alicia es la que sube una nueva versión de su programa mientras Bernardo está en la playa surfeando.

Para permitir esta multiplexación estadística, era necesario un mecanismo que permitiera a las estaciones remotas detectar un error en la transmisión inicial para poder saber que debían de re-transmitir. Este objetivo se conseguía de manera indirecta. Honolulu volvia a transmitir por el enlace de bajada todo lo que recibía por el enlace de subida. Si la estación remota escuchaba en el enlace de bajada lo mismo que acababa de transmitir en el enlace de subida, sabía que la transmisión se había realizado de manera exitosa. En caso contrario, era probable que hubiera habido un error en la transmisión inicial y por tanto era una buena idea retransmitir los datos.

La guerra de los estándares

"Lo maravilloso de los estándares es que hay muchos entre los que escoger”, Grace Hopper, según UNIX-HATERS Handbook (PDF) página 9 o 49. Al final del siglo pasado, dos estándares competían por la supremacía en el ámbito de las redes de area local inalámbricas. La alternativa estadounidense, promovida por el IEEE, se basaba en principios más sencillos y directos. En cambio, la alternativa europea, promovida por la ETSI (European Telecommunications Standards Institute) era más sofisticada y ofrecía tasas de transmisión más elevadas, la posibilidad de priorización de tráfico y servicios diferenciados. Los fabricantes prefirieron la opción desarrollada por el IEEE, en su versión más simple y sin características opcionales, ya que era más fácil de implementar.

Evidentemente, un enfoque más sencillo permitía lanzar productos al mercado en un plazo más corto de tiempo, lo cual se traducía en una mayor cuota de mercado. Este hecho facilitó la adopción del estándar del IEEE en detrimento de la alternativa del ETSI. El estandar en cuestión, denominado IEEE 802.11 pertenece a la familia 802, que también incluye al IEEE 802.3 (Ethernet). Con el paso del tiempo, el estándar IEEE 802.11 fue mejorado para incluir algunas de las prestaciones que ya se consideraban en la propuesta inicial del ETSI, como tasas de transmisión más elevadas y diferenciación de servicios.

Ensanche del espectro para evitar la industria, la ciencia y la medicina

El propósito de una red de área local es que cada uno pueda construir su propia red local, sin necesidad de coordinarse con nadie más. Pero cuando se trata del uso del espectro radioeléctrico, los usuarios tienen que ceñirse a una estricta regulación para evitar interferencias con otros. Las redes IEEE 802.11 (popularmente conocidas como WiFi) consiguen esquivar esa estricta regulación, así como el consiguiente pago por las licencias del espectro. La explicación es que las redes WiFi operan en una banda sin licencia situada en los 2.4 GHz que se reservó para usos industriales científicos y médicos (y se conoce por sus iniciales en inglés ISM). En esta banda también operan los dispositivos bluetooth, los teléfonos inalámbricos, e incluso los hornos microondas.

La especificación 802.11 original publicada en 1997 especificaba velocidades de 1 y 2 Mbps en la banda de radio de microondas ISM y en la banda de infrarrojos (aunque en esta última no se llegó a implementar). En la banda ISM es necesario utilizar técnicas de espectro ensanchado para evitar las interferencias en la medida de lo posible. Habitualmente las técnicas de modulación intentan transmitir el máximo número de bits por hercio (bits/Hz) para la eficiente utilización del espectro. En el caso del espectro ensanchado el objetivo es el opuesto: tratamos de extender la señal en un gran ancho de banda, con la consiguiente reducción de bits por hercio. La ventaja es que esta técnica diluye las interferencias de banda estrecha.

Salto de frecuencia

La técnica de espectro ensanchado más sencilla es el salto de frecuencia (obsoleto en la actualidad en WiFi) que funciona, como su nombre indica, saltando rápidamente de una frecuencia a otra. El salto de frecuencia se inventó en diferentes ocasiones a lo largo de la primera mitad del siglo XX, una de ellas por la actriz Hedy Lamarr y el compositor George Antheil. A través de su primer marido (de un total de seis), Lamarr se interesó en el problema de guiar torpedos de una manera que evitara las interferencias y la detección por parte del enemigo. El salto de frecuencia evita la interferencia de banda estrecha, pero para funcionar necesita que emisor y receptor estén perfectamente sincronizados.

Antheil, que había creado la composición Ballet Mécanique para una colección de pianolas sincronizadas ayudó a resolver el problema de la sincronía utilizando un rollo de pianola. A pesar de que la patente a Lamarr y Antheil se concedió en 1942, la importancia del invento no se reconocería hasta los 90, cuando la revolución inalámbrica tuvo lugar.

Espectro ensanchado por secuencia directa en 802.11

La versión de 1997 del estándar 802.11 también permitía velocidades de 1 o 2 Mbps utilizando espectro ensanchado por secuencia directa (Direct Sequence Spread Spectrum, DSSS). En vez de mover una transmisión de banda estrecha por distintas frecuencias de la banda de 2,4GHz , DSSS transmite una señal que ocupa un ancho de banda mucho mayor de manera continua. El señal original en una transmisión DSSS es de un ancho de banda reducido comparado con el ancho de banda de la señal de espectro ensanchado DSSS. En transmisión se extiende el señal y en recepción se recupera el señal original utilizando un mecanismo de correlación. En ese proceso, se rechaza la gran mayoría de la interferencia de banda estrecha.

Es un poco como leer un libro en la playa. Los granitos de arena sobre las letras hacen la lectura del texto difícil. Para evitarlo, podríamos llevar un libro con letras grandes y mantenerlo a una distancia mayor que la habitual. Los granitos de arena son más pequeños comparados con el texto de mayor tamaño con lo que la interferencia es menor.

IEEE 802.11-1997 utiliza una tasa de señalización de símbolo de 1MHz, con uno o dos bits por símbolo codificados con una modulación por desplazamiento de fase diferencial binaria o en cuadratura (DBPSK o DQPSK), donde la fase de una señal portadora es desplazada para codificar los bits. Diferencial significa que no es el valor absoluto de la fase lo que importa, sino la diferencia relativa al símbolo anterior. Véase nuestro artículo sobre DOCSIS para más detalles sobre los bits se codifican en símbolos).

La señal DBPSK/QBPSK de 1MHz se multiplica a continuación por una secuencia pseudoaleatoria que contiene 11 "chips" por cada símbolo (una tasa de chip de 11MHz). Al transmitirse sobre el canal, el espectro ocupado por esta señal se ensancha, ya que la tasa de chip es mayor que la tasa de bit. Cuando esa señal de banda ancha sufre una interferencia de banda estrecha, el impacto es leve ya que la mayoría de de la señal transmitida no se ve afectada. El receptor toma la secuencia de chips y la multiplica por la misma secuencia pseudoaleatoria que utilizó el transmisor. Este proceso recupera la señal PSK original.

802.11b: modulación por código complementario

El poder transmitir datos de manera inalámbrica a velocidades algo mayores que 100 kilobytes por segundo es impresionante desde el punto de vista de que funcione, pero para las aplicaciones del mundo real algo más de velocidad no vendría nada mal. Aquí es donde IEEE 802.11b, que especificó velocidades de 5.5Mbps y 11Mbps en 1999, entró en juego.

El simple hecho de incrementar la tasa de símbolo y, con ella, la tasa de chip de DSSS, permitiría mayores tasas de bit pero utilizaría un mayor ancho de banda. En vez de eso, 802.11b codifica bits adicionales en la secuencia de chips DSSS, utilizando un esquema de modulación por código complementario (complementary code keying, CCK). La tasa de 5.5Mbps utiliza 4 secuencias de chip de 8 bits (codificando dos bits), mientras que la tasa de 11Mbps utiliza 64 secuencias (seis bits). Combinados con los dos bits DPSK, esto suma un total de cuatro o 8 bits por símbolo a una tasa de símbolo de 1.375MHz.

802.11a: multiplexación por división de frecuencia ortogonal

Para 802.11a (1999), el IEEE seleccionó una tecnología muy diferente a DSSS/CCK: la multiplexación por división de frecuencia ortogonal (OFDM). DSSS es una técnica de una sola portadora, ya que hay una sola señal de velocidad elevada (es decir, banda ancha) modulando la portadora. Esto tiene algunos inconvenientes, ya que un canal de banda ancha presenta diferentes comportamientos a diferentes frecuencias y necesita ecualizarse. Es mucho más conveniente enviar un número mayor de portadoras y utilizar señales de velocidad reducida (banda estrecha) para modular cada una de ellas. Hasta que los procesadores de señales digitales potentes (DSP) estuvieron disponibles no se pudo utilizar el algoritmo de transformada rápida de Fourier inversa (IFFT) para empaquetar de manera cercana (en frecuencia) un número elevado de subportadoras sin que hubiese demasiada interferencia entre ellas.

En lugar de tener una sola señal que ocupe la friolera de 22 MHz de espectro radioeléctrico como con DSSS, 802.11a transmite 48 subportadoras con datos a través de 20MHz. Debido a que hay tantas subportadoras, las frecuencias de bit y de símbolo para cada una de ellas son bastante bajas: la frecuencia de símbolo es de uno cada 4 microsegundos (250 kHz), que incluye un intervalo de guarda de 800 nanosegundos entre símbolos. La baja frecuencia de símbolos y el tiempo de guarda para cada subportadora son las armas secretas de la OFDM. Le confieren robustez frente a los reflejos o interferencias por trayectoria múltiple. Las ondas de radio de 2,4 GHz tienen la tendencia de rebotar en todo tipo de obstáculos, de modo que un receptor generalmente obtendrá múltiples copias de la señal transmitida, en la que los reflejos llegarán ligeramente retrasados. Se trata de un fenómeno que algunos de nosotros recordamos de los días de la televisión analógica, donde se mostraba como efecto de imagen fantasma.

Un problema que surge con la transmisión de radio es que las señales invariablemente "resuenan" en la banda de radio y aparecen copias de la transmisión en cuestión en frecuencias más bajas o más altas, causando interferencia en transmisiones cercanas. Esto hace que resulte extremadamente complejo transmitir señales cercanas en frecuencia, que es de hecho exactamente lo que hace la OFDM. Consigue hacerlo porque las frecuencias de la portadora y las frecuencias de símbolo se eligen de modo que los perfiles frecuenciales sean "ortogonales": allí donde una de las portadoras es máxima, las otras se silencian. Es parecido al modo en que los aviones de la Primera Guerra Mundial podían disparar a través del arco de la hélice; tanto la hélice como las balas de la ametralladora ocupan el mismo espacio, pero se intercalan con cuidado para no interferir unas con las otras.

Con técnicas como BPSK, QPSK, 16QAM, o 64QAM (1, 2, 4, o 6 bits por símbolo), esto suma entre 250 kbps y 1,5 Mbps por subportadora. La velocidad de bit total en bruto para todas las 48 subportadoras es, por tanto, de 12 a 72 Mbps.

A diferencia de 802.11-1997 y de 802.11b, 802.11a utiliza una banda ISM de 5 GHz en lugar de la banda ISM de 2,4 GHz. A pesar de que llevó su tiempo resolver la disponibilidad de 5 GHz en todo el mundo, lo cual no ayudó precisamente al despliegue de 802.11a, la banda de 5 GHz tiene mucho más espacio que la apretada banda de 2,4 GHz. Las señales de 5 GHz se absorben más fácilmente así que no llegan tan lejos. Esto suele ser una desventaja, pero al mismo tiempo puede ser una ventaja: las redes cercanas no interfieren tanto porque las señales no pasan muy bien a través de los muros y los suelos.

Aunque el 802.11a fue incorporado en parte del espacio empresarial, no se puede decir que tuviera un éxito arrollador. Lo que se necesitaba era una manera de pasar las velocidades de 802.11a a la banda de 2,4 GHz de un modo compatible con versiones anteriores. Esto es exactamente lo que hace 802.11g (2003) mediante el uso de OFDM al estilo 802.11a en la banda de 2,4 GHz (aunque suma mecanismos de "protección" adicionales [de los que se habla más adelante] para la coexistencia de 802.11b).

802.11n: mucha, mucha, mucha más velocidad

Sorprendentemente, 802.11g no consiguió saciar la sed de más velocidad. Así que IEEE volvió al trabajo de estandarización para intentar encontrar nuevos modos de transmitir más bits a través del éter. En esa ocasión no se consiguió con ninguna modulación nueva, sino que se utilizaron varias técnicas que combinadas permitían velocidades de bits mucho más elevadas y, más importante, un rendimiento mucho mejor en el mundo real. En primer lugar, el número de subportadoras OFDM se incrementó a 52, lo cual llevó la velocidad de bits en bruto hasta 65 Mbps.

El segundo aumento de velocidad procedió de MIMO: múltiples entradas y múltiples salidas. Con MIMO, una estación Wi-Fi puede enviar o recibir múltiples flujos de datos a través de diferentes antenas al mismo tiempo. La señal entre cada combinación de antenas de emisión y recepción toma una ruta ligeramente diferente, de modo que cada antena ve cada flujo de datos transmitido a una potencia de señal ligeramente diferente. Eso posibilita la recuperación de los múltiples flujos de datos al aplicar una buena dosis de procesamiento de señales digitales.

Todos los sistemas Wi-Fi 802.11n, excepto los teléfonos móviles, son compatibles con al menos dos flujos, pero también es posible que lo sean con tres o cuatro. El uso de dos flujos aumenta la velocidad a 130 Mbps. El tercer mecanismo para aumentar la velocidad es una opción para utilizar "canales anchos". Los canales de 40 MHz, en lugar de 20 MHz, permiten 108 subportadoras, lo cual lleva a una velocidad de bits de 270 Mbps con 2x2 MIMO (dos antenas utilizadas por el emisor y dos antenas utilizadas por el receptor). Como opción, el intervalo de guarda se puede reducir de 800 a 400 nanosegundos, añadiendo otro 10 por ciento de aumento de velocidad, lo que hace que la velocidad de bits total alcance 300 Mbps para 2x2 MIMO, 450 Mbps para 3x3 MIMO, y 600 Mbps para 4x4 MIMO. Sin embargo, puesto que la banda de 2,4 GHz ya está muy ocupada, algunos proveedores solo aplican canales anchos en la banda de 5 GHz.

Para acabar, pero no por ello menos importante, el 802.11n permite concatenar múltiples paquetes en una sola transmisión y utilizar confirmaciones de bloque, reduciendo el número de bits de sobrecarga que hay que transmitir.

Propagación e interferencia

La comunicación por cable utiliza un medio estrictamente controlado para la propagación de señales. Un cable tiene propiedades predecibles y está, hasta cierto punto, aislado del mundo exterior. En la comunicación inalámbrica, la situación es justo al revés. El comportamiento del medio de transmisión es bastante impredecible y la interferencia es una realidad. Los ingenieros de radio recurren a métodos estadísticos para describir la propagación radioeléctrica, ya que el modelado con precisión es demasiado complejo. El canal atenúa (debilita) la señal y además introduce dispersión (extensión) a través del tiempo y la frecuencia. Solo en circunstancias ideales, en un espacio libre y abierto, la señal simplemente se propaga desde el transmisor hasta el receptor a través de una ruta única.

Obviamente, las condiciones de propagación típicas están lejos de ser perfectas. Las ondas de radio alcanzan todo tipo de objetos que causan reflejos. La señal que llega al receptor es la suma de un gran número de señales que siguieron rutas diferentes. Algunas señales siguen una ruta corta y por lo tanto llegan rápidamente. Otras siguen una ruta más larga y les lleva más tiempo llegar. Si dejamos caer una canica en un fregadero lleno de agua, veremos como las ondas se propagan y reflejan en todas las direcciones, haciendo que el comportamiento general de las ondas sea difícil de predecir. En algunos lugares, se unen dos frentes diferentes de ondas, creando una onda más fuerte. En otros lugares, las ondas que vienen de diferentes direcciones se anulan entre sí. Produciendo una interferencia destructiva.

Es probable que su vecino también posea algún equipo Wi-Fi. Y hay otros dispositivos, como dispositivos Bluetooth u hornos microondas, que operan en la misma banda que el Wi-Fi. Obviamente, toda esta interferencia se suma a los problemas anteriormente citados y hace que sea difícil detectar correctamente y decodificar la señal que queremos.

La conclusión es que la calidad de la señal que vamos a observar es bastante impredecible. Lo mejor que podemos hacer es estar preparados para tratar con la heterogeneidad de la calidad de las señales. Si las condiciones de propagación son buenas y la interferencia es baja, podemos transmitir a velocidades de datos elevadas. En condiciones de propagación complejas, con mucha interferencia, tenemos que recurrir a velocidades de datos reducidas. Esta es la razón por la que los dispositivos Wi-Fi ofrecen distintas velocidades de conexión y adaptan constantemente la velocidad de datos a las condiciones del entorno.

Canales y superposición

El Wi-Fi en la banda ISM de 2,4 GHz utiliza 14 canales a intervalos de 5 MHz (los canales 12 y 13 no están disponibles en América del Norte y hay otras peculiaridades específicas de países. El canal 14 es un caso especial). Sin embargo, las transmisiones de DSSS tienen un ancho de 22 MHz aproximadamente, así que el estándar 802.11b especifica que dos trasmisiones deberían estar a 25 MHz la una de la otra para evitar interferencias indebidas. De aquí parte la creencia generalizada de que se deben usar los canales 1, 6, y 11 para evitar superposiciones. Sin embargo, la vida real es más complicada y no se puede resumir en una recomendación tan simple.

Los receptores generalmente no son tan buenos como le gustaría a IEEE, lo cual hace que una señal que es lo suficientemente fuerte pueda causar interferencias, incluso aunque se encuentre a 5 canales de distancia. Pero utilizar canales que se superponen ligeramente suele funcionar bien, especialmente si los diferentes transmisores están a una cierta distancia. Por lo tanto, si usted cuenta con cuatro estaciones base Wi-Fi, es probable que sea mejor utilizar los canales 1-4-8-11 en América del Norte en lugar de tener dos estaciones base en el mismo canal en la configuración 1-6-11. En Europa y en muchas otras partes del mundo 1-5-9-13, que proporciona la separación de 20 MHz necesaria para 802.11g y 802.11n, es posible. En la banda de 5 GHz donde está 802.11a, y en ocasiones 802.11n, los canales tienen un ancho de 20 MHz, aunque todavía se numeran en intervalos de 5 MHz (así que tres cuartas partes de los números de canal siguen sin utilizarse). Algunos canales de 5 GHz solo están disponibles si no están siendo utilizados para otros propósitos (como radar), así que únicamente se seleccionan cuando se configura la selección del canal a "auto". Esto varía de un país a otro.

Por supuesto, hoy en día somos pocos los que tenemos el lujo de partir y repartir una banda de 2,4 GHz para nosotros solos. No es raro ver una docena o más de redes Wi-Fi en un barrio residencial. Afortunadamente, eso no significa que todas estas redes vayan a producir muchas interferencias. La mayoría de las redes están inactivas gran parte del tiempo, y la multiplexación estadística triunfa. Sin embargo, si usted se encuentra atrapado entre redes Wi-Fi activas, merece la pena experimentar un poco.

En algunos casos, la mejor opción es seleccionar el mismo canal que utilizan sus vecinos. De esta manera, su red y la de sus vecinos irán transmitiendo por turnos amigablemente. El hecho de esperar por las transmisiones de sus vecinos reducirá su rendimiento máximo, pero ellos también tendrán que esperar por usted, así que podrá transmitir a la velocidad máxima cuando sea su turno. Como alternativa, si elige un canal que se superpone en gran medida con una red de un vecino fuerte y activa, las dos redes no "se verán" entre sí y en lugar de ir por turnos generarán interferencia cuando transmitan al mismo tiempo, reduciendo las velocidades de transmisión utilizables.

Pero por otra parte, en el caso de una red más remota, la superposición puede ser una opción mejor que compartir el mismo canal. La distancia añadida reduce la interferencia, así que la velocidad de transmisión sigue siendo elevada y su red no tendrá que esperar que se completen las transmisiones de la otra. Si todo lo demás es igual, elija el canal 1 o la opción disponible más elevada. De esta manera, la superposición solo puede venir de una dirección.

Quién transmite: control del acceso a los medios

Con solo un canal de radio para enviar y recibir y múltiples dispositivos que podrían tener datos que transmitir, obviamente es necesario algún protocolo para que los dispositivos operen bien y vayan por turnos a la hora de transmitir. Imagine que participa en una conferencia telefónica. Si todos los participantes en la llamada hablan al mismo tiempo no será muy eficaz. Lo ideal es que los diferentes participantes que tienen algo interesante que compartir hablen por turnos. Aquellos que no tienen nada que decir, simplemente pueden permanecer en silencio.

Es una norma de cortesía natural no interrumpir a los demás, es decir, hay que esperar a que la otra parte termine antes de que empecemos a hablar. Por lo tanto, las diferentes partes escuchan el medio antes de hablar, y se abstienen de intervenir cuando otra persona está hablando. En la jerga de las redes inalámbricas esto se conoce como "acceso múltiple por detección de portadora" (CSMA). CSMA resuelve parte del problema, pero sigue permitiendo que dos dispositivos empiecen a transmitir al mismo tiempo, después de que finalice la transmisión anterior, creando una colisión. Y a diferencia de Ethernet por cable, los dispositivos Wi-Fi no pueden detectar las colisiones cuando se producen.

La solución a este problema es que, después de esperar hasta que se haya terminado una transmisión pendiente, las estaciones que quieren transmitir esperen un tiempo aleatorio. Si tienen suerte, elegirán al azar un tiempo diferente, y una comenzará la transmisión mientras la otra todavía está esperando, y se evitará una colisión. Esta solución se denomina , de manera muy apropiada, "evasión de colisiones" (CA). La capa de control del acceso a los medios 802.11 combina CSMA y CA, abreviado a CSMA/CA. Asimismo, los dispositivos también esperan un tiempo aleatorio entre paquetes si tienen que transmitir múltiples paquetes, para dar a otros dispositivos la posibilidad de intervenir.

La implementación de CSMA/CA utilizada en IEEE 802.11 se conoce como "función de coordinación distribuida" (DCF). La idea básica es que antes de transmitir un paquete, las estaciones eligen un contador de "espera" al azar. A continuación, mientras el canal está inactivo, las estaciones disminuyen su contador de espera en uno en cada ranura temporal. La ranura temporal es de 9 o 20 microsegundos, según la versión 802.11 que nos ocupe. Al final, el contador de espera se pone a cero y en ese momento la estación transmite su paquete. Después de la transmisión, la estación elige un nuevo valor de espera y la historia se repite. De esta manera, las colisiones solo se producen cuando dos estaciones eligen el mismo valor de espera al azar.

Si el paquete no llega al receptor previsto, se vuelve a transmitir. Por supuesto, un transmisor necesita saber si la transmisión ha sido exitosa o no para decidir si hace falta una retransmisión. Por esta razón, una estación IEEE 802.11 responde inmediatamente con un paquete de confirmación después de recibir un paquete de datos “unicast” destinada a ella (no se hace esto para paquetes multicast o broadcast porque hay más de un receptor. Estos paquetes se envían simplemente a una velocidad mucho más baja para disminuir la probabilidad de error). Si un transmisor no recibe esta confirmación, programará la retransmisión del paquete. Si se perdiera una confirmación, se produciría una retransmisión innecesaria.

Equidad

DCF es un protocolo "justo" en el sentido de que todas las estaciones tienen la misma oportunidad de transmitir. Este concepto de equidad conlleva un comportamiento en cierto modo extraño que se conoce como "anomalía del rendimiento", que se reduce a "el más lento marca el ritmo". Si se encuentra justo al lado de su punto de acceso y tiene buenas condiciones de canal, puede comunicarse de forma inalámbrica a una velocidad relativamente rápida, digamos 54 Mbps. Pero si otra persona se conecta al mismo punto de acceso desde una sala u oficina remota, utilizaría una velocidad de datos más lenta, digamos 6 Mbps. Y, ¡sorpresa!, la velocidad que usted obtiene se reduce casi a la que tendría si estuviese utilizando una velocidad de 6 Mbps usted mismo. ¿Por qué? DCF está siendo simplemente "justo" y ustedes dos percibirán un rendimiento similar. El número de intentos de transmisión va a ser el mismo para los dos. La única diferencia es que el dispositivo remoto ocupará el canal durante más tiempo (ya que utiliza una velocidad de datos reducida), mientras que el dispositivo más cercano ocupará el medio durante un período de tiempo corto para cada intento de transmisión. Viene a ser como compartir un carril con un camión grande y lento. Hay quien diría que este es un concepto de equidad un tanto particular.

CSMA parte del supuesto de que todas las estaciones oyen las transmisiones de las demás. Y no tiene por qué ser así. Es posible que dos estaciones interfieran entre sí aunque no puedan detectar las transmisiones de la otra. Por ejemplo, imaginemos dos estaciones que transmiten a un mismo punto de acceso pero que no pueden oírse entre sí. Esto puede suceder si hay un obstáculo entre las estaciones o si bien se encuentran a gran distancia a cada lado del punto de acceso. Esto se conoce como el "problema del nodo oculto".

El problema del nodo oculto. Digamos que la estación 1 empieza a transmitir. La estación 2 no oye la transmisión de la estación 1, así que también empieza a transmitir. El punto de acceso escucha ambas transmisiones pero no consigue decodificar ninguna de ellas porque se superponen y causan una gran interferencia entre sí. El punto de acceso no envía ninguna confirmación, así que las dos estaciones retransmiten y vuelven a colisionar. El proceso se repite y el rendimiento efectivo de la red es casi nulo.

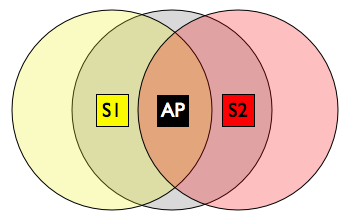

Este problema se puede aliviar utilizando un protocolo de acuerdo de cuatro pasos, que consiste en cuatro mensajes diferentes: petición de envío (RTS), listo para emitir (CTS), datos y confirmación (ACK). Una estación que está lista para transmitir envía una RTS que contiene un campo que indica cuánto tiempo necesita estar reservado el canal. El destinatario, en este caso el punto de acceso (AP), responde con un mensaje CTS que también contiene la duración de la reserva del canal. Idealmente, este CTS será recibido por todos los transmisores interferentes que están en el rango de transmisión de AP, que pospondrán sus transmisiones para evitar colisión, así que la estación que había emitido inicialmente la RTS transmite su paquete de datos sin incidentes y el punto de acceso envía una confirmación.

Puesto que los paquetes de RTS, CTS y ACK son paquetes de señalización cortos, la posibilidad de que se produzcan errores y colisiones es baja. Si se produce una colisión entre dos paquetes RTS, será una colisión breve, por lo tanto no se desperdicia demasiado tiempo del canal. Al utilizar el protocolo de acuerdo de cuatro pasos, se evitan las colisiones entre los paquetes de datos largos. Pero los paquetes extra RTS/CTS añaden sobrecarga adicional, reduciendo el tiempo del canal disponible para la transmisión de datos del usuario. Así que RTS/CTS solo está habilitado para los paquetes largos, y se suele deshabilitar completamente.

Sobrecarga y cuello de botella MAC

¿Se ha preguntado alguna vez por qué casi nunca puede obtener 30 Mbps de su hardware de 54 Mbps? Échele la culpa al cuello de botella MAC. En primer lugar, las trasmisiones se retrasan durante un tiempo aleatorio, lo cual implica necesariamente que hay momentos en el que el medio está inactivo y, por lo tanto, el tiempo del canal se desperdicia. El tiempo del canal también se desperdicia cuando se produce una colisión. E incluso las transmisiones satisfactorias vienen con una cantidad de tiempo de sobrecarga. Las transmisiones inalámbricas están precedidas por secuencias o preámbulos de entrenamiento que permiten que el receptor se adapte a las condiciones del canal y se sincronice para la transmisión de datos. El paquete de confirmación también representa cierta sobrecarga. Además, el paso de transmisión a recepción y viceversa, no es gratuito, el hardware necesita algún tiempo para volver a configurarse. Tampoco ayuda que el Wi-Fi transmita todas las tramas Ethernet en lugar de solo los paquetes IP en las tramas Ethernet.

Toda esta sobrecarga es aceptable para paquetes largos, pero a medida que los paquetes son más cortos, la cantidad fija de sobrecarga por paquete se hace relativamente más larga. El problema es que a medida que las velocidades de datos de capa física aumentan debido a la evolución de la tecnología, los paquetes se hacen más cortos. Como consecuencia, la sobrecarga relativa aumenta. Para un paquete corto, ¡el tiempo malgastado en forma de sobrecarga puede ser mayor que el tiempo que se utiliza para la transmisión de los datos del usuario! Se trata del problema del cuello de botella MAC: a partir de un cierto punto, por mucho que aumente la velocidad de la capa física, el usuario no percibirá ninguna mejora significativa de rendimiento.

El problema era especialmente grave con el lanzamiento de la enmienda estándar IEEE 802.11n que utiliza MIMO, canales más anchos, y más eficiencia en general para permitir velocidades de capa física hasta 600 Mbps. A pesar de esta impresionante cifra, el cuello de botella MAC habría limitado el rendimiento real a menos de los 100 Mbps del Ethernet por cable. Evidentemente resultaba inaceptable.

La solución fue agregar paquetes múltiples en paquetes de mayor tamaño con la consiguiente reducción de la sobrecarga relativa. Cada vez que una estación obtiene acceso al canal, transmite varios paquetes agregados y solo paga la penalización de sobrecarga una vez. Este esquema simple fue crucial para evitar el cuello de botella MAC y romper la barrera de rendimiento real de 100 Mbps en 802.11n.

Protección contra vecinos lentos

Se suele afirmar que las redes 802.11 operan a la misma velocidad que el aparato más lento al que están conectadas. Afortunadamente esto no es cierto, aunque la anomalía de rendimiento mencionada anteriormente entra en juego cuando los dispositivos más lentos empiezan a transmitir. En una red mixta los dispositivos más rápidos tendrán que reducir su velocidad en mayor o menor medida para coexistir con los dispositivos más antiguos. Esto comenzó con 802.11b, que introdujo cabeceras más cortas que el 802.11 original de 1 y 2 Mbps. Pero estas cabeceras más cortas solo se pueden utilizar cuando todos los participantes de la red son sistemas 802.11b. Más problemática resulta la coexistencia entre 802.11b y 802.11g, porque los sistemas 802.11b ven las señales OFDM como un ruido sin sentido y no funciona la detección de portadora.

Así que si uno o más sistemas 802.11b están presentes en un canal, las transmisiones OFDM deben ser protegidos por paquetes RTS/CTS de DSSS (o simplemente por los paquetes CTS). El paquete CTS anuncia una duración que abarca el paquete CTS de DSSS, el paquete de datos OFDM, y la confirmación OFDM para el paquete de datos, así que las estaciones de DSSS permanecen en silencio durante ese tiempo. La protección se activa si se detecta alguna estación DSSS, incluso aunque sea parte de alguna otra red lejana al final de la calle. Esta protección obstaculiza seriamente el estilo de 802.11g; el rendimiento cae un 50 por ciento. Pero sin ella, los sistemas DSSS podrían transmitir en mitad de una transmisión OFDM, para detrimento de ambas.

Debido a que 802.11a, g, y n utilizan la modulación OFDM, la compatibilidad con versiones anteriores es más fácil aquí: parte del encabezado MAC se envía a la velocidad de 802.11a/g, para que los dispositivos más antiguos conozcan la duración de la transmisión. El resto de campos de encabezado y los datos se transmiten, a continuación, a velocidades de 802.11n. Dado que las redes 802.11a son relativamente poco frecuentes, por lo general no es un problema ejecutar solo en modo 802.11n en la banda de 5 Ghz. Pero hacerlo en la banda de 2,4 GHz puede no hacerle gracia a sus vecinos con 802.11g.

Estandarización y certificación

Hasta ahora, hemos utilizado los términos Wi-Fi ("fidelidad sin cables", jugando con la expresión "hi-fi" [alta fidelidad]) y IEEE 802.11 de forma intercambiable, pero hay una diferencia. El IEEE es el organismo de normalización a cargo del estándar IEEE 802.11, utilizando procedimientos largos y tediosos. Por ejemplo, el trabajo en la enmienda IEEE 802.11n se inició en 2002. Antes de 2007, la mayoría de los detalles técnicos estaban resueltos, pero hubo que esperar hasta 2009 antes de que la nueva versión del estándar 802.11 fuese oficial. No ayuda que las empresas que colaboran en el IEEE sean competidoras en el mercado, y que pueda resultar todo un éxito para una empresa que su tecnología patentada forme parte de un estándar.

La Wi-Fi Alliance, por otra parte, es un consorcio de la industria que certifica que el hardware cumple con una especificación y puede interoperar. La Wi-Fi Alliance lleva a cabo algunas pruebas y (tras el pago de las tasas correspondientes) certifica que un producto cumple con la especificación. Los productos certificados llevan un logo que identifica que cumplen con el estándar. Como cabe esperar, las certificaciones siguen el estándar 802.11, pero en ocasiones pueden precisar la implementación de ciertas opciones, o incluso la no presencia de opciones consideradas obsoletas, como WEP.

Seguridad

Si conecta su ordenador al enrutador de su casa a través de ese fiel cable UTP, es muy improbable que el vecino cotilla pueda espiar sus hábitos de navegación. Pero en una conexión inalámbrica, la situación puede ser muy diferente. Las ondas de radio no reconocen límites de propiedad; cualquiera puede adquirir una antena direccional y recopilar datos inalámbricos desde una distancia segura. El tacaño de su vecino podría aprovecharse de su conexión de banda ancha en lugar de pagar por una conexión propia por cable o ADSL. Para evitar estas eventualidades, las primeras versiones del estándar Wi-Fi venían con "privacidad equivalente por cable" (WEP) para proteger la red inalámbrica. Desafortunadamente, WEP no está a la altura de las circunstancias. WEP se desarrolló en la época en la que el gobierno estadounidense no permitía la exportación de cifrados robustos, así que WEP en un principio utilizaba tamaños de clave de 40 bits, lo cual es intencionalmente demasiado corto para ofrecer algo más que una simple ilusión de seguridad (las versiones posteriores eran compatibles con claves de 104 bits).

Las claves de 40 o 104 bits se combinan con un vector de inicialización de 24 bits para un total de 64 o 128 bits. El algoritmo de cifrado en WEP es el Rivest Cipher RC4. Sin embargo, con el paso de los años se han puesto de manifiesto muchas debilidades en WEP, hasta el punto de que ahora WEP puede descifrarse en cuestión de minutos. Esto llevó a la Wi-Fi Alliance a presentar un nuevo marco de seguridad llamado Acceso Protegido Inalámbrico (WPA), mientras que el IEEE empezó a trabajar en un nuevo estándar de seguridad denominado IEEE 802.11i.

El objetivo de WPA era respaldar la seguridad Wi-Fi sin tener que sustituir el hardware, mientras que el objetivo del IEEE era construir algo esencialmente mejor. WPA introduce el Protocolo de integridad de clave temporal (TKIP) que reutiliza las capacidades de RC4 de las tarjetas existentes Wi-Fi, pero crea una nueva clave de cifrado para cada paquete. Esto consiguió evitar la mayor parte de las vulnerabilidades entonces conocidas de WEP. WPA2 es el nombre de Wi-Fi Alliance para IEEE 802.11i, que utiliza CCMP, un protocolo que combina el modo de operación contador para el cifrado con autenticación de mensaje basada el modo de encadenamiento de bloques. CCMP se basa en el muy utilizado algoritmo de cifrado AES.

Tanto WPA como WPA2 están disponibles en formas Personal y Enterprise. WPA2 Personal utiliza una clave precompartida de 256 bits (PSK), que se usa para negociar las claves de cifrado del paquete. Como es evidente, las personas que no conocen la PSK no pueden acceder a la red. WPA2 Enterprise utiliza una plétora de protocolos adicionales para que el usuario pueda dar un nombre de usuario y una contraseña, que se coteja con un servidor de autenticación remoto. Utilice siempre solo WPA2 con CCMP/AES, a menos que no le quede otro remedio porque necesite compatibilidad con un equipo muy antiguo.

Aunque la comunicación inalámbrica, especialmente en la concurrida banda ISM, está cargada de peligros ocultos, colaboradores de IEEE y Wi-Fi Alliance han conseguido guiar con éxito la tecnología LAN inalámbrica desde sus modestos comienzos hasta la razonable fiabilidad y el alto rendimiento del que disfrutamos hoy en día. Cada vez que se presentó un obstáculo, se introdujo nueva tecnología para sortearlo, al tiempo que el mercado en rápido crecimiento mantenía los precios bajo presión. ¿Qué más podíamos pedir?

Leer más:

- ars technica/Gears & Gadgets/Essential toys, tools, and hardware

- Recent stories by Iljitsch van Beijnum in ars technica (Historias recientes de Iljitsch van Beijnum en ars technica)